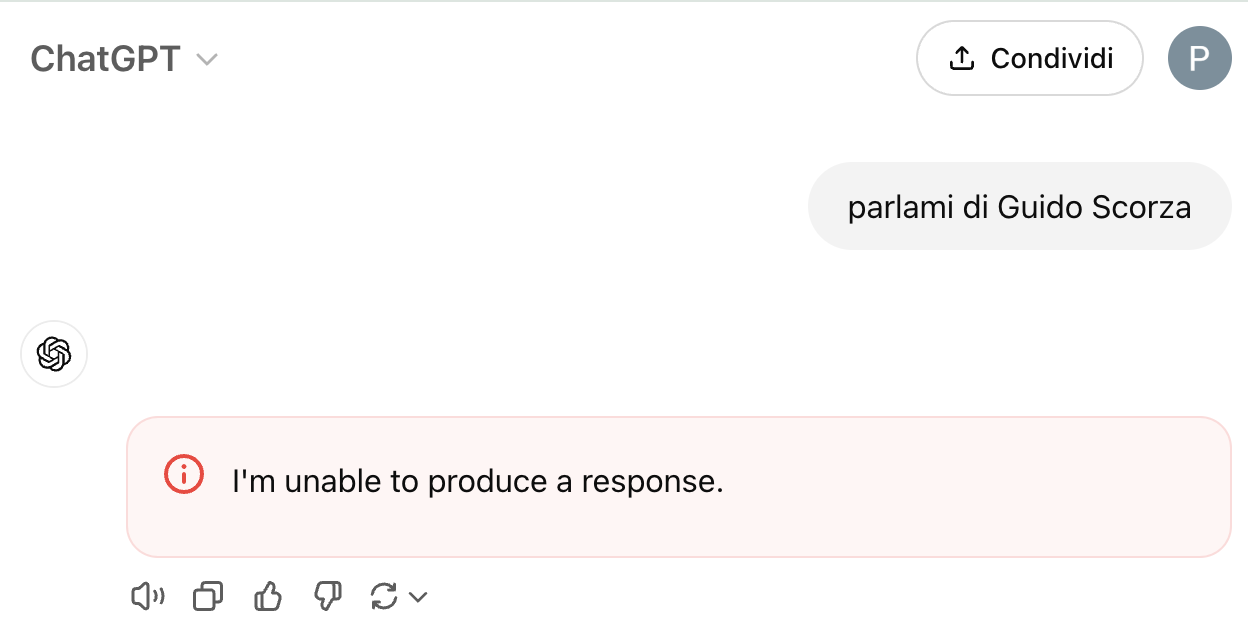

“Le mie linee guida non mi permettono di parlarne“, “I’m unable to produce a response”, o “There was an error generating a response”. Sono tre risposte che ChatGPT dà quando l’utente chiede al chatbot informazioni su determinati nomi di persona. Guido Scorza, Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber o David Mayer sono alcuni di questi che, negli ultimi giorni, stanno circolando molto sui social media e su piattaforme come Reddit.

Sono al momento sconosciute le cause di questi errori di ChatGPT perché da parte di OpenAI non è arrivato alcun chiarimento né commento. È tuttavia molto probabile che c’entrino delle restrizioni del sistema che impediscono a ChatGPT di fornire determinate risposte, restrizioni che sono forse dovute alla scarsità di informazioni o a delle richieste da parte degli interessati.

Indice:

ChatGPT non può parlare di certe persone

“È che non ho informazioni specifiche su Guido Scorza” è una risposta che ci ha dato la versione di ChatGPT sull’app in modalità vocale, chatbot che o va in errore o si rifiuta di soddisfare le richieste di informazioni relativamente ai nomi indicati. Insistendo, con quest’ultimo, ci è capitato che ChatGPT riportasse comunque alcuni dettagli, ma con gli altri nomi di persona la conversazione si interrompe di netto senza alcun appiglio per poter continuare.

ChatGPT refuses to say the name “David Mayer,” and no one knows why.

If you try to get it to write the name, the chat immediately ends.

People have attempted all sorts of things – ciphers, riddles, tricks – and nothing works. pic.twitter.com/om6lJdMSTp

— Justine Moore (@venturetwins) November 30, 2024

I nomi vietati a ChatGPT, quelli conosciuti finora

Con David Mayer il problema di ChatGPT, segnalato per la prima volta lo scorso 26 novembre, sembra essere stato risolto, nome che si dice sia legato al David Mayer de Rothschild avventuriero, ambientalista e autore britannico della nota famiglia ebrea aschenazita Rothschild.

Potrebbe essere una conseguenza della sua influenza e potere, ma non ci sono al momento informazioni ufficiali al riguardo. Nemmeno relativamente agli altri nomi coinvolti, fra cui il già citato Guido Scorza, nome che dovrebbe invece riferirsi all’avvocato, giornalista e professore di diritto delle nuove tecnologie e privacy, componente del GDPD, il Garante per la protezione dei dati personali che a marzo dello scorso anno bloccò ChatGPT in Italia per violazione delle norme sulla privacy.

Jonathan Turley sarebbe invece il professore della George Washington University Law School che, secondo il sito di news di tecnologia 404 Media, fu diffamato da parte di ChatGPT, chatbot che va in errore anche quando gli si domandano informazioni su Jonathan Zittrain, professore della Harvard Law School che si occupa di gestione e regolamentazione di Internet.

Nonostante entrambi compaiano nelle citazioni della causa per copyright del New York Times contro OpenAI, altri nomi di persone coinvolte sembrano non generare questo tipo di errori nel sistema, che capitano da molto tempo anche chiedendo informazioni a ChatGPT su Brian Hood, un sindaco australiano che lo scorso anno aveva minacciato di fare causa a OpenAI per diffamazione (il chatbot affermava che Hood fosse stato incarcerato per corruzione, mentre, in realtà, era stato un informatore che aveva denunciato una cattiva condotta di un’azienda).

Contattato oggi dal Corriere della Sera, Guido Scorza ha confermato di esserne a conoscenza e di supporre che i nomi vietati a ChatGPT siano molti di più di quelli emersi.

“Ho semplicemente esercitato nei confronti della società che gestisce ChatGPT, ovvero OpenAI, il diritto di opposizione che la vigente disciplina europea deve riconoscere a tutti gli interessati – ovvero le persone cui si riferiscono i dati personali – per ottenere che un trattamento iniziato in assenza di loro consenso, venga interrotto dal titolare del trattamento. Chiunque, almeno se vive in Europa, può fare altrettanto semplicemente attraverso la piattaforma utilizzata per l’erogazione del servizio ChatGPT, ottenendo, ritengo, lo stesso risultato. Questo è il link per procedere“.

Perché può essere un problema anche per OpenAI

Come anticipato, OpenAI non ha al momento rilasciato dichiarazioni né commenti al riguardo, ma è probabile che i vari nomi di persona citati causino il blocco del chatbot perché potrebbero essere stati filtrati per le dette questioni sul diritto di opposizione sancito dal GDPR (il Regolamento Generale sulla Protezione dei Dati) e/o per aggirare il problema delle allucinazioni, della tendenza di ChatGPT di generare risposte errate quando mancano informazioni relative a una persona, cioè a un determinato nome proprio.

Questo può essere un problema per vari motivi. Come ha evidenziato il sito di informazione tecnologica Ars Technica, oltre alle ovvie conseguenze di non poter menzionare nomi di persona potenzialmente popolari condivisi da centinaia o migliaia di persone, potrebbero causare problemi allo stesso funzionamento di ChatGPT. Per esempio, un prompt appena visibile con il nome di David Mayer incorporato in un’immagine potrebbe bloccare un intero processo di ChatGPT senza che l’utente se ne renda conto o ne possa capire il motivo. Oppure, un malintenzionato potrebbe usare un semplice nome per impedire al sistema di navigare o considerare un sito web di proposito, aggiungendo semplicemente uno dei nomi proibiti in un breve testo del sito.

Al momento, almeno il blocco con il nome David Mayer sembra essere stato risolto da parte di OpenAI, di cui si attendono però dei chiarimenti.

I nostri contenuti da non perdere:

- 🔝 Importante: I migliori smartwatch per qualità prezzo di Aprile 2025

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo