Intelligenza artificiale di qua, NPU di là, Neural engine a destra, modelli in locale a sinistra. Tranquilli, non siete di certo gli unici confusi in questi mesi dove l’utilizzo della parola AI è diventato smodato, quasi fastidioso.

Si tratta di marketing, dagli smartphone ai nuovi AI notebook passando per gli AI gadget, tutti promettono funzioni miracolose ed alcuni ci riescono pure ma tutti cadono nel tranello di non essere onesti con i consumatori finali.

La premessa è d’obbligo e la si farà fin quando non sarà a tutti chiaro che non esiste NPU, non esiste un mobile SoC, non esiste un gadget AI-related che possa funzionare meglio per l’intelligenza artificiale della componente che è alla base di questa rivoluzione: la GPU.

Indice:

AI on device: confusione e fumo negli occhi

Ora è chiaro che grazie agli sviluppi del cloud computer, uno smartphone o un notebook possono accedere ad output di AI generativa in un click. Tutto è in cloud ma appena la connessione sparisce la magia è finita. Poi ci sono i mini modelli che possono girare in locale, un Galaxy S24 Ultra è in grado di fare tante piccole operazioni in locale ed offline. Per quanto possa essere impressionante si deve sempre specificare che si tratta di piccole operazioni che nulla hanno a che fare con i modelli di AI che stanno trainando il settore.

Il nome più in voga di tutti è ChatGPT e se state pensando che con un hardware da smartphone o una NPU su un notebook sarà possibile far girare offline un modello del genere senza intoppi, svegliamoci dal sonno perché non è ancora possibile.

ChatRTX di NVIDIA è la promessa più vicina al futuro

Torniamo alle GPU, quelle che popolano i server di tutto il mondo, quelle che muovono le AI di tante aziende, quelle che per la maggior parte sono di NVIDIA, leader del settore da prima che anche il ristoratore sotto casa si facesse scrivere il menù da ChatGPT.

Per mettere un piede in quello che sarà il futuro delle AI, personalizzate e chiuse nel pieno rispetto della privacy, nel peno rispetto dei dati per l’addestramento, è necessario battere alla porta di chi regge l’industria, NVIDIA.

Attenzione, non si sta parlando di sviluppatori che da terminale si mettono a lavorare con AI, si sta parlando di utenti comuni che vogliono avere un assaggio del futuro che forse con ChatRTX non è nemmeno così lontano. Il termine GPU deve diventare un mantra quando si parla di AI e se ne avete una nel vostro PC, se ne avete una NVIDIA dalla serie RTX 3000 a salire, allora mettetevi comodi perché con soli 100 GB di spazio disponibile ed almeno 8 GB di memoria RAM dedicata alla GPU potrete provare ChatRTX.

NVIDIA ChatRTX: AI on device flessibile con RAG

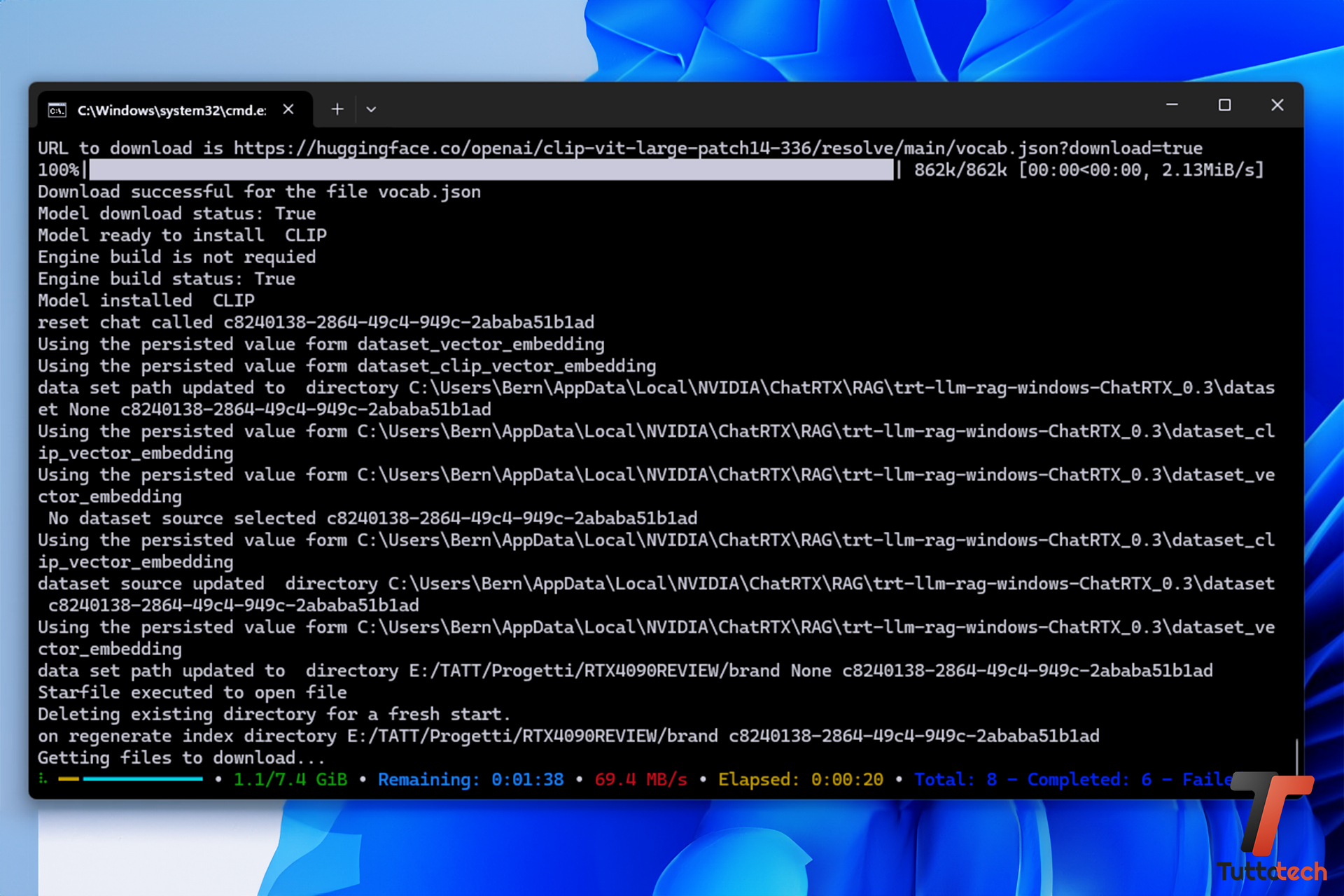

ChatRTX è ancora una demo ma tanto avanzata che, volendo, è già possibile utilizzarla come assistente di tutti i giorni sfruttando un grande modello linguistico (LLM) da alimentare con i propri documenti, appunti, foto e altri dati. ChatRTX supporta vari formati di file, tra cui testo, pdf, doc/docx (con LLM) e jpeg, gif e png (con CLIP). Basta dargli in pasto la cartella contenente i tuoi file e li utilizzerà per generare risposte in pochi secondi.

In parole povere, avrete il vostro ChatGPT personalizzato, sicuro, che funziona offline e che lavora anche con immagini. Il tutto anche con un interfaccia grafica semplice da utilizzare e che integra link rapidi per installare più modelli. Questo è un passaggio fondamentale, oggi per provare a giocare con i modelli di AI sul proprio PC è necessario fare più installazioni e passaggi, ChatRTX fa tutto da solo, basta solamente un doppio click per installare il programma.

Le conoscenze richieste per interagire con ChatRTX sono elementari, si aprirà un interfaccia grafica nel browser web con due grandi finestre. La prima riguarda la selezione dei modelli di AI da utilizzare con anche gli altri opzionali da scaricare. La seconda invece riguarda il dataset da utilizzare che può essere qualsiasi cartella con i vostri dati nel PC o il dataset di default del modello AI.

La terza e ultima finestra è quella di interazione che può avvenire sia con testo che con voce. Qui va specificato lo status di beta, ChatRTX non ricorda ancora il contesto, quindi verrà dimenticata ogni interazione precedente e questo rende la conversazione meno scorrevole e naturale. Tant’è, è una beta e presto arriverà qualche nuovo aggiornamento con l’interfaccia grafica standalone e magari il contesto sempre presente.

Sebbene possa sembrare un aggregatore di modelli, in realtà non è così perché per poter utilizzare un dataset personalizzato con i nostri dati in tempo reale ChatRTX utilizza la RAG, una sorta di framework AI, che consente ai modelli di integrare ai loro dataset di base, la molteplicità di informazioni fornite dall’utente. Per poter rendere tutto questo processo molto più snello e user friendly, NVIDIA ha ricompilato alcuni modelli AI per usare l’accelerazione TensorRT-LLM via CUDA Core.

- Minstral 7B Int4

- Gemma 7B Int4

- ChatGLM 6B Int4

- Llama2 13B Int4

- Clip

Va specificato che per sfruttare in maniera corretta i vari dataset personali andrà aggiornato sempre il percorso dei vari file. Ad ogni modifica dei file o del loro contenuto andrà refreshato il dataset per permettere la creazione dei vettoriali.

Piattaforma e altri dettagli di NVIDIA ChatRTX

Semplificare il funzionamento di ChatRTX non era semplice. Ci sarebbero molte più cose da dire sul funzionamento RAG, Tensor, memoria dedicata e via dicendo ma al momento è meglio concentrarci sulle prime impressioni di questa beta di ChatRTX.

Abbiamo installato ChatRTX su una build con RTX 4090 Founders Edition accompagnata da Intel Core i9 14900K su piattaforma Z790 Dark Hero di ASUS. Airflow, dissipazione e via dicendo tutto al top, non abbiamo trascurato nulla ma sono dettagli quasi inconsistenti perché la prima cosa da sottolineare e che ChatRTX non è di alcun peso alla RTX 4090.

Abbiamo provato anche con una RTX 4080 Super Founders Edition ma il risultato è il medesimo, sia con 4090 e sia con 4080S, non si arriva nemmeno ad un utilizzo della GPU del 40%. Poco carico sulla GPU per pochissimi secondi tutto a scapito dei consumi che restano decisamente bassi. Una partita a Cyberpunk 2077 con Path Tracing si fa sentire di più.

Questo dovrebbe già tranquillizzare chi ha timore del peso di ChatRTX. La pesantezza del programma è legata al peso dei modelli e a quanto spazio VRAM si richiede. Per questo motivo NVIDIA consiglia l’utilizzo anche sulle RTX 3000 ma che abbiano almeno 8 GB di VRAM a salire. La RTX 4090 con i suoi 24 GB di RAM dedicata GDDR6X (384 bit) non è minimamente impensierita.

- Temperature: sotto 40°

- Consumo: costanti 7W

- Consumo picco max 4 sec: 125W

- VRAM occupata: 6GB

Sicuramente l’utilizzo di una CPU di fascia alta come il 14900K riduce ulteriormente i tempi di inferenza ma in realtà grosso del lavoro è sulla GPU ed i tempo di attesa sono praticamente nulli, le risposte arrivano all’istante, stessa cosa per la ricerca di immagini con CLIP. La cosa che richiede qualche secondo in più di attesa è lo switch tra i modelli o la generazione di un dataset particolarmente grande. Nulla di preoccupante.

La prova: ChatRTX diventa un content creator

Abbiamo fatto prove su prove, test su test e già in questo stato di beta, ChatRTX è l’esempio migliore, più concreto di ciò che si può fare con un sistema AI in locale e personalizzato. Piccola precisazione, sebbene con la maggior parte dei modelli ChatRTX comprenda ed in alcuni casi risponda anche in italiano, ci siamo resi conto che una prova in inglese, in questa fase, è sicuramente più accurata.

Abbiamo dato in pasto a ChatRTX un dataset di script di video review, video opinioni, approfondimenti, tutti tradotti alla buona in inglese senza particolare impegno. Abbiamo chiesto a ChatRTX di generare nuovi script per video Youtube mantenendo uno stile simile a quello del dataset, la stessa durata media e lo stesso lessico.

Il risultato è impressionante nonostante il prodotto in lingua inglese. dandogli in pasto meno di 20 script, ChatRTX è in grado di comportarsi come un content creator non di primo pelo, ecco. Promettiamo di non utilizzare gli script e le idee generate da ChatRTX ma fidatevi che il risultato medio è estremamente convincente.

Abbiamo fatto anche altre prove, dando in pasto dei pdf di prenotazioni di viaggi, hotel e altri dettagli turistici e nonostante qualche difficoltà nel leggere alcuni pdf davvero incomprensibili anche per noi umani, il risultato anche in questo caso è valido anche se ancora impreciso in alcuni casi nel puntare alla fonte giusto del documento. ChatRTX ti risponde se gli chiedi quando devi partire, a che ora, dove devi alloggiare e cosa visitare. Con un dataset più preciso, è in grado di tirare fuori un itinerario di viaggio.

Di prove ne abbiamo fatte un bel po’, anche le più strane, anche tentativi a vuoto e la generalizzazione che possiamo tirare fuori è che quanto più si è precisi nel fornire un buon dataset, più ChatRTX sarà efficace. Una generalizzazione, una banalità per molti ma doveroso sottolinearlo perché quando ChatRTX sarà fuori dalla beta, quando verrà dato in mano ai consumatori finali, potete solo immaginare che tipo di dataset gli verrà dato in pasto. Avremo un AI con il mal di testa.

Molto molto interessante per professionisti fotografi, creator e via dicendo la possibilità di sfruttare il modello CLIP che permette di utilizzare una ricerca visiva. In questo caso gli abbiamo dato in pasto un dataset fatto di fotografie di alcuni prodotti che abbiamo provato in passato, abbiamo creato una cartella molto grande che ci ha messo un po’ per digerire eppure la riposta è sempre fulminea. Potete chiedere di mostrarvi le foto che mostrano il soggetto X o che all’interno c’è l’oggetto Y, ChatRTX con CLIP è molto preciso nella risposta e nel puntare alla fonte corretta.

NVIDIA ChatRTX è solo l’antipasto: tutto è in costruzione

Se ChatRTX di NVIDIA vi sembra già qualcosa di assurdo ed impensabile solo pochi mesi fa, avete ragione. Effettivamente quando il tuo PC da gaming riesce a diventare un assistente AI che gira in locale, senza fare il minimo sforzo ed utilizza i tuoi dati, nel totale rispetto della privacy, un po’ fa impressione.

Ma a queste sensazione ci sarà da abituarsi perché nel mondo AI tutto è in costruzione. OpenAI continua a rilasciare nuove versione di GPT, i modelli presenti su ChatRTX avanzano a vista d’occhio ed anche se in ritardo, Google ed Apple non staranno di certo a guardare.

Quello che è importante tenere in mente è che le fondamenta di questo mondo qui sono piantate nelle GPU, nei server potenziati da GPU NVIDIA Blackwell B200, i veri portenti da dover osservare con attenzione e studiare perché senza quella potenza lì, senza quella agilità di calcolo, tutto questo sviluppo repentino non sarebbe possibile.

ChatRTX è un primo passo di NVIDIA nello sbloccare anche per i suoi utenti consumer alcune features di AI generativa che non sono regalate al mondo del gaming. Il DLSS da anni fa miracoli, da anni si migliora e riesce a generare sempre più frame grazie all’intelligenza artificiale, quasi che lo si da per scontato. Non dovrebbe essere così, la vera marcia in più delle schede video NVIDIA è il parco software a corredo, già ricchissimo di funzioni AI e che presto si arricchirà anche di una nuova versione di ChatRTX. Perché tutto è in costruzione, tutto è in divenire ma tutto si regge sulle spalle di NVIDIA. Qualcosa vorrà pur dire.

I nostri contenuti da non perdere:

- 🔝 Importante: I dazi faranno aumentare i prezzi di iPhone e tech in Italia?

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo