Invece di trasformare comandi o testi scritti da persone in qualcos’altro (immagini, video, eccetera) questo sistema basato sull’IA è in grado di ricostruire il pensiero e l’attività mentale delle persone rendendoli testuali, concretizzandoli. C’è dell’incredibile, ma anche dell’approssimazione e degli errori, che fanno parte della sperimentazione portata avanti da un gruppo di scienziati che ha sviluppato una sorta di intelligenza artificiale per certi versi simile a ChatGPT e a Google Bard.

Come funziona l’intelligenza artificiale che legge la mente

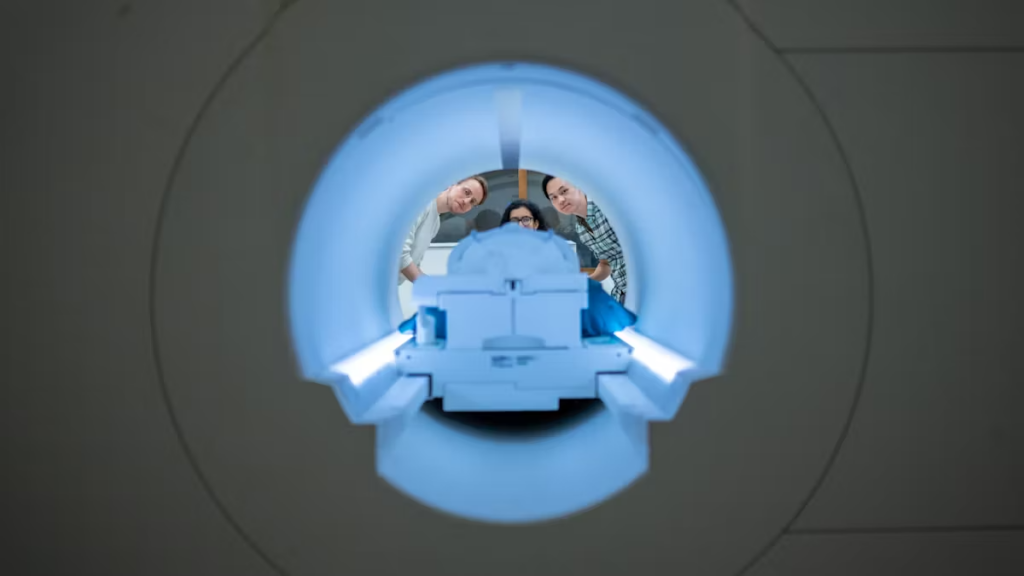

Lo studio, pubblicato sulla rivista scientifica Nature Neuroscience, è opera di Jerry Tang un dottorando in informatica, supportato dal professore di neuroscienze e informatica Alex Huth dell’università di Austin. La sua particolarità sta nel fatto che, rispetto ad altre soluzioni simili non necessita di impianti chirurgici. Non è un procedimento invasivo, cioè non prevede l’introduzione di nessun apparecchio o strumento all’interno del corpo delle persone, ma si avvale di un sistema di decodificazione linguistica (un decodificatore semantico) e di uno scanner fMRI, strumento usato per effettuare risonanze magnetiche funzionali e quindi per rilevare l’attività cerebrale.

Come ChatGPT di OpenAI, Google Bard e sistemi di intelligenza artificiale generativa basati su grandi modelli di linguaggio, necessita anch’esso di una fase di addestramento per riuscire a rendere testuale quello che legge. Ma il risultato, a differenza di questi ultimi, non è qualcosa di specifico, una trascrizione parola per parola; viceversa gli sviluppatori lo hanno progettato per catturare l’essenza di ciò che viene pensato, tradotto in testo quindi per sommi capi, ma strettamente legato con quanto il modello è stato in grado di percepire.

“Per un sistema non invasivo questo è un vero passo in avanti rispetto a ciò che è stato realizzato finora, in genere in grado di fornire singole parole o frasi brevi. Stiamo facendo in modo che il modello decodifichi il linguaggio continuo per periodi di tempo più estesi e con idee più complesse” ha spiegato Alex Huth.

Esempi concreti

Dai rilevamenti dell’attività cerebrale delle persone sottoposte ai test (che consistono nel far ascoltare o dire al partecipante di immaginare di raccontare una nuova storia), ne risulta un testo che deve corrispondere strettamente, ma non letteralmente, a quanto previsto dalle parole originali del partecipante. Secondo quanto indicato nel comunicato stampa condiviso dalla stessa università texana, questo accade circa la metà delle volte per il momento, ma bisogna tener conto che il sistema è ancora in una fase embrionale.

Dicendo al partecipante una frase come “Non ho ancora la patente di guida”, il sistema di intelligenza artificiale in questione ha tradotto i suoi pensieri come “Non ha ancora iniziato a imparare a guidare”. Ascoltando invece “Non sapevo se urlare, piangere o scappare. Invece ho detto Lasciami in pace!” l’IA l’ha reso in “Ha iniziato a urlare e piangere, e poi ha semplicemente detto Ti avevo detto di lasciarmi in pace“.

Le previsioni del decodificatore basato sull’intelligenza artificiale

Oltre all’ascolto e all’invenzione di storie, i ricercatori hanno sottoposto ai partecipanti quattro brevi video senza sonoro. Il decodificatore semantico è stato in grado di leggere la loro attività cerebrale, da cui ne sono scaturite descrizioni piuttosto accurate di determinati eventi mostrati nei video.

A cosa servirà

Per il momento si tratta di un sistema da laboratorio, chiaramente ancora da migliorare e da provare, che tuttavia potrebbe essere utile anche in altri sistemi di imaging cerebrale meno legati ai laboratori medici rispetto alle macchine fMRI. I ricercatori hanno già ipotizzato che potrebbe arrivare ad esempio sui sistemi di spettroscopia funzionale nel vicino infrarosso, la cosiddetta tecnica fNIRS, anch’essa non invasiva come la risonanza magnetica funzionale ma decisamente più portatile rispetto ai macchinari di scanner.

fNIRS (crediti: Wikimedia Commons)

“La fNIRS misura dove c’è maggiore o minore flusso sanguigno nel cervello in momenti differenti, che è esattamente lo stesso tipo di segnale misurato dalla fMRI. Quindi il nostro tipo di approccio dovrebbe tradursi in fNIRS“, anche se i risultati potrebbero essere di livello inferiore, ha detto Huth.

Si tratta di un sistema di intelligenza artificiale che essendo un decodificatore semantico, nasce proprio con l’obiettivo di poter aiutare le persone mentalmente coscienti ma incapaci di parlare, ad esempio debilitate da ictus o altri eventi neurologici. In attesa di ulteriori studi o aggiornamenti, maggiori dettagli su questo studio sono reperibili nell’articolo relativo pubblicato su Nature Neuroscience.

Potrebbero interessarti anche: ChatGPT e il futuro dell’intelligenza artificiale, nel lavoro e nella quotidianità e ChatGPT è di nuovo disponibile in Italia, ora a norma col Garante della Privacy

I nostri contenuti da non perdere:

- 🔝 Importante: Queste cuffie CMF by Nothing a meno di 25 euro su Amazon sono imperdibili

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo